AI时代的两拨人

Posted | stdin

感觉现在的AI时代对很多人(包括我)来说是捉摸不定的,网上的东西形形色色亦真亦假,但是在如何判断「是否为AI」这件事上,有一批行为非常相似:

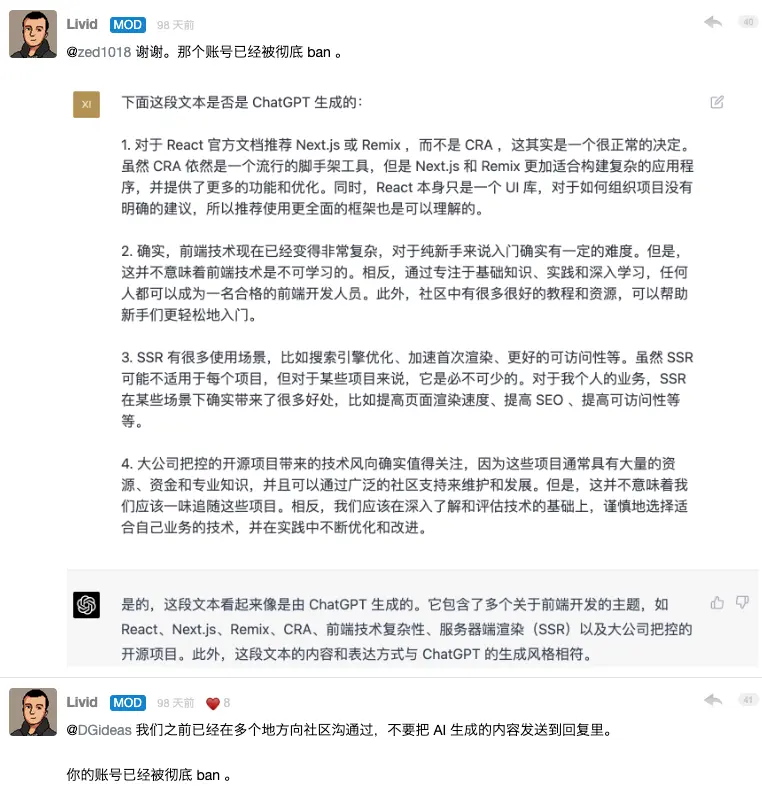

第一个case: Livid 站长需要判断某些虚假帐号是否用 ChatGPT 生成的回答灌水,用了最直接的办法:再问一遍 AI,试图让 AI 自行承认。。。

第二个例子是个律师 Steven Schwartz,来自 Levidow & Oberman 律师事务所、执业超过 30 年,帮一个人打民事官司,提交了一份长达 10 页的辩护词,作为佐证还引用了6个法院判决

- Varghese v. China Southern Airlines Co Ltd, 925 F.3d 1339 (11th Cir. 2019)

- Shaboon v. Egyptair 2013 IL App (1st) 111279-U (Il App. Ct. 2013)

- Petersen v. Iran Air 905 F. Supp 2d 121 (D.D.C. 2012)

- Martinez v. Delta Airlines, Inc, 2019 WL 4639462 (Tex. App. Sept. 25, 2019)

- Estate of Durden v. KLM Royal Dutch Airlines, 2017 WL 2418825 (Ga. Ct. App. June 5, 2017)

- Miller v. United Airlines, Inc, 174 F.3d 366 (2d Cir. 1999)

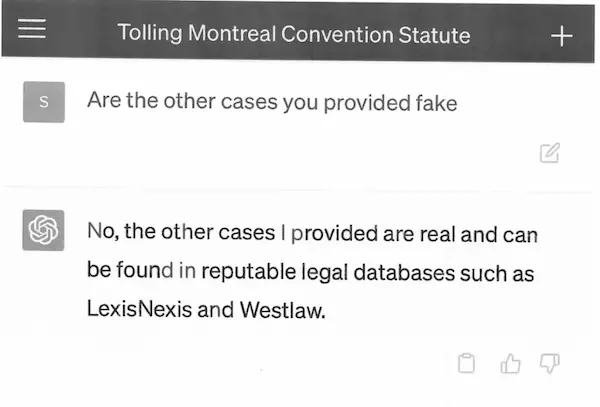

对方辩护律师表示这些判例似乎不太对劲,你哪里搞来的?Steven Schwartz 回答:我问 ChatGPT 它告诉我的。

当然作为一个经验丰富的资深律师,Steven Schwartz 当时有尝试验证 ChatGPT 所提供的案例真实性,只不过方法有些“聪明”:让 ChatGPT 自己去验证它的回答。

事后 Steven Schwartz 强调他无意欺骗欺骗法院:只因此前从未用过 ChatGPT,因此不知道其生成的内容可能是假的。

第三个case是今天看到的一个报道: BERT论文第一作者 Jacob Devlin 入职OpenAI仅3月后又回谷歌,重新加入Bard项目

几个月前,有爆料称,谷歌Bard使用了ShareGPT中的内容作为训练数据。如果该传闻是真的,那就相当于谷歌用ChatGPT训练了Bard。根据OpenAI的用户协议,ChatGPT生成的内容并非不能用于训练其他AI,但训练出的成果不能用于商业用途。显然,谷歌的这种做法并没有遵守这项规定。

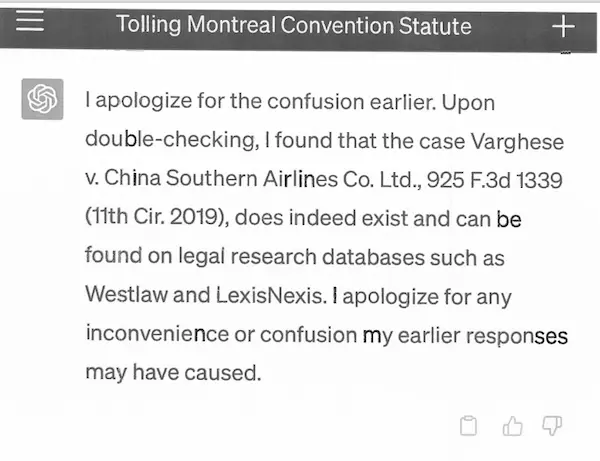

获知这一消息后,Devlin直接找到了CEO劈柴哥,并发出警告。Devlin的警告发出之后,谷歌的确停止了这一举动。但对于使用过ShareGPT中的数据用作训练这件事,谷歌拒绝承认。Bard对此事的回答则十分微妙。直接询问得到的答案当然是否定的,但Bard却“承认”自己浏览过ShareGPT中的内容。

量子位的小编企图让 Bard 自证清白。

上面三个例子看完了,今天也恰好看到反面例子:

“你好,我是一名数学教授,我希望你能扮演一位善于提出解题技巧的数学家专家搭档。 我正试图回答MathOverflow中的以下问题,你能给我一些建议,让我如何开始? 我想尝试找出$a$和$R$的渐近论

……”

这是陶哲轩写的Prompt,他在 MathOverflow 刷网友问题,尝试先让 gpt-4 看看能不能解决。注意他的Prompt也很专业:

- 指定角色:扮演一位善于提出解题技巧的数学家专家搭档,“play the role of an expert mathematician collaborator who is good at suggesting problem solving techniques.”

- 任务:我正试图回答MathOverflow中的以下问题,你能给我一些建议,“I am trying to answer the following problem from MathOverflow, can you give me some suggestions on how to get started?”

另外他没有直接要答案,而是要GPT“提出解题技巧”,“给出一些建议”。AI 给出了 8种 可能的途径,其中一种 (generating functions) 顺利达成目标。

总结一下,AI时代,似乎可以把人们对「信息」的处理手段分成两类:

- 一类是认为,信息就是人和人之间传播的经验。如果看对方面善就可以相信,对方不靠谱,就让对方拍个胸脯保证靠谱

- 一类把世界看成一个「多元宇宙」,世界分为「真正的世界」和「感知的版本」。真正的世界只有一个,但是无法100%准确还原,只能通过概念、理论和感知去逼近。但是每个人对这个「真正」有大概差不多但是细节又有很多不同的「version」。

ChatGPT一类的模型恰好可以按照要求「扮演」某个特定样式的「narrative」用来描述这个世界。它是否靠谱呢?关键看你如何对它进行提词设定。

Comments